Ogni volta che accendiamo un computer o, attraverso lo smartphone, navighiamo sul web, lasciamo una traccia del nostro passaggio, la cosiddetta impronta digitale: una ricerca fatta, la tessera fedeltà che usiamo quando facciamo la spesa, quello che leggiamo e condividiamo sui social media, il film visto su Netflix, gli acquisti che paghiamo utilizzando il telefono e così via. L’impronta digitale che lasciamo è composta da dati che dicono molto su di noi e sul nostro comportamento: raccontano chi siamo, quali sono i nostri gusti e le nostre preferenze, quali le nostre abitudini d’acquisto e quali le nostre modalità di relazione. È questo il processo alla base dei Big Data, termine che letteralmente significa “grandi dati”.

Big Data, cosa sono e come sono nati

Quando si parla delle caratteristiche dei Big Data, si utilizza la definizione elaborata da Gartner (società americana di ricerca e consulenza) nel 2001, secondo cui i Big Data si distinguono dagli altri in base alle “tre v”:

- Volume. I Big Data sono, come suggerisce il termine, grandi quantità di dati. Le fonti sono numerose, e includono le informazioni raccolte sui social media, sui siti che frequentiamo e che prevedono una profilazione, sino a quelle fornite dall’uso che facciamo dai cosiddetti oggetti intelligenti (Internet of Things).

- Velocità. Il flusso con cui viaggiano queste informazioni è notevolmente aumentato e le aziende devono essere in grado di gestire e processare questi dati in pochissimo tempo, se non in tempo reale, per poterli sfruttare a proprio vantaggio.

- Varietà. I dati provengono da diverse fonti e per questo si presentano in forme distinte: dai dati strutturati e numerici nei database tradizionali, ai documenti di testo non strutturati, come e-mail, video, audio e transazioni finanziarie.

Recentemente a questa definizione si sono aggiunte altre due v, “valore” e “veridicità”, ad indicare che i dati sono una risorsa preziosa, una volta analizzati, ma soltanto se si tratta di dati veritieri, che rispecchiano la realtà.

Quella dei Big Data non è non una tecnologia recente. La possibilità di usare grandi quantità di dati per orientare scelte aziendali è nata intorno agli anni ’70, con la comparsa dei primi data center. Tuttavia, lo sviluppo e l’uso di questa tecnologia è stato, ed è tutt’ora, profondamente legato alla nascita e al progresso di altre tecnologie. In primo luogo, gestire una tale quantità di dati richiede soluzioni di archiviazione adeguate e non troppo care ed è stato grazie allo sviluppo di framework open-source come Hadoop (e di altre soluzioni simili negli anni successivi), che l’uso massivo dei dati ha conosciuto un pieno sviluppo.

Ulteriore spinta all’utilizzo della Big Data Analysis (il processo di analisi e interpretazione dei Big Data) è avvenuta con la nascita dei dispositivi mobili quali smartphone e tablet e il conseguente boom di applicazioni ad essi dedicate. Anche i social media, una grande fonte di dati, hanno fornito un boost a questa tecnologia e ad oggi innovazioni quali l’Internet of Things, il 5G, l’intelligenza artificiale e (soprattutto) il machine learning hanno portato l’utilizzo dei Big Data a un ulteriore livello. Si tratta di una tecnologia che ha il potenziale di rivoluzionare molti ambiti della nostra vita quotidiana, dai servizi offerti nelle città, a un nuovo modo (smart) di gestire le infrastrutture, a una vera e propria rivoluzione in campo medico.

Come le aziende possono utilizzare la Big Data Analysis

Un modello, quello della Big Data Analysis, che oggi sembra essere il preferito da moltissime aziende per intercettare i gusti e le abitudini dei propri clienti. Tuttavia, trattandosi di enormi quantità di informazioni, occorre una strategia chiara per poterle convertire in asset per il business. Oltre a individuare gli obiettivi finali dell’utilizzo dei dati e le fonti da cui provengono, è fondamentale sviluppare competenze e strumenti adatti all’interpretazione.

Un dato, infatti, è utile soltanto dopo che è stato analizzato e interpretato. I dati grezzi fotografano un evento che si sta verificando, ci dicono cosa sta avvenendo, ma è solo attraverso il processo di Data Analysis che si può risalire alle cause dell’avvenimento e si possono fare predizioni per il futuro.

Le aziende che operano nel campo della vendita di beni e servizi, ad esempio, possono usare i dati a loro disposizione per monitorare i comportamenti e le preferenze dei consumatori, così da poter massimizzare le possibilità di vendita, inviando sconti personalizzati. I dati ricevuti dai feedback dei clienti possono invece essere utilizzati per risolvere dei problemi e anticipare le tendenze future: aziende come Netflix, ad esempio, usano la Big Data Analysis per analizzare le preferenze degli abbonati ed elaborare così modelli di predizione delle loro aspettative, che guideranno la scelta dei prodotti su cui investire.

I Big Data vengono utilizzati anche nella manutenzione di infrastrutture e macchinari, grazie allo sviluppo dell’Internet of Things, capace di raccogliere una gran messe di dati, come temperatura, frequenza di utilizzo, malfunzionamenti e così via. L’analisi di questi dati permette di predire guasti o cedimenti della struttura, guidando negli interventi di manutenzione preventiva. Un esempio è il nuovo ponte di Genova, progettato da Renzo Piano, dotato di sensori intelligenti e robot che “scannerizzano” la struttura per monitorarne lo stato. Le informazioni che verranno archiviate saranno usate anche come banca dati per la progettazione di altre infrastrutture intelligenti nel Paese.

Big Data Analysis, perché è ancora poco diffusa tra le piccole e medie imprese italiane

Nonostante le potenzialità dei Big Data siano evidenti, una porzione di imprese nel nostro Paese fatica ad elaborare strategie basate sulla Big Data Analysis: si tratta soprattutto delle PMI, piccole e medie imprese, che non sempre sono in grado di accollarsi i costi che il processo comporta. Infatti, se è vero che i progressi fatti nei metodi di archiviazione dei dati hanno reso le soluzioni di storage più economiche, è altrettanto vero che quella dei Big Data è una tecnologia che cresce in modo molto rapido: gli esperti spiegano infatti che il volume di dati raddoppia ogni due anni e per le aziende è difficile tenere il passo.

C’è poi un problema legato alle competenze della forza lavoro. Come già evidenziato, il dato è utile soltanto dopo che è stato analizzato e interpretato e per farlo si richiedono competenze digitali e analitiche avanzate. Per questo, la figura del Data Scientist ha acquisito nell’ultimo decennio sempre più importanza: era già stata descritta come “professione più sexy del XXI secolo” dalla rivista Harvard Business Review nel 2012 ed è ad oggi, secondo un rapporto LinkedIn, la terza professione più ricercata negli Stati Uniti. Per capire quanto sia complesso il processo di Big Data Analysis basti pensare che un Data Scientist spende dal 50 all’80% del suo tempo ad analizzare e interpretare i dati prima di poterli utilizzare.

Di queste competenze, il nostro Paese ha un elevatissimo bisogno. L'ultimo rapporto DESI (Indice della Digitalizzazione dell’Economia e della Società) pubblicato dalla Commissione Europea ha sottolineato che al 42% della popolazione mancano competenze digitali di base, mentre gli impiegati nel settore delle tecnologie dell’informazione e della comunicazione sono appena il 2,8% del totale. Situazione che si traduce in un grande ritardo, soprattutto delle piccole e medie imprese, sull’applicazione di strategie di business basate sui Big Data.

Secondo i dati dell’Osservatorio Big Data Analytics & Business Intelligence della School Management del Politecnico di Milano, il 93% delle grandi imprese investe in progetti di Analytics, contro il 62% delle Pmi. Tuttavia, è chiaro ormai a tutti gli attori coinvolti che non si può non investire in questa tecnologia, alla luce soprattutto dei grandi progressi che si stanno ottenendo combinando i Big Data con il machine learning (apprendimento automatico delle macchine).

Il machine learning si basa, infatti, proprio sulla disponibilità di grandi flussi di dati, che forniscono ai computer gli strumenti da cui imparare. Una possibile applicazione per le aziende è nel campo della sicurezza informatica, dove grazie proprio all’analisi dei dati è possibile rilevare in tempo reale le minacce provenienti dall’esterno, individuare comportamenti rischiosi degli impiegati ed elaborare strategie e soluzioni volte alla prevenzione di attacchi esterni.

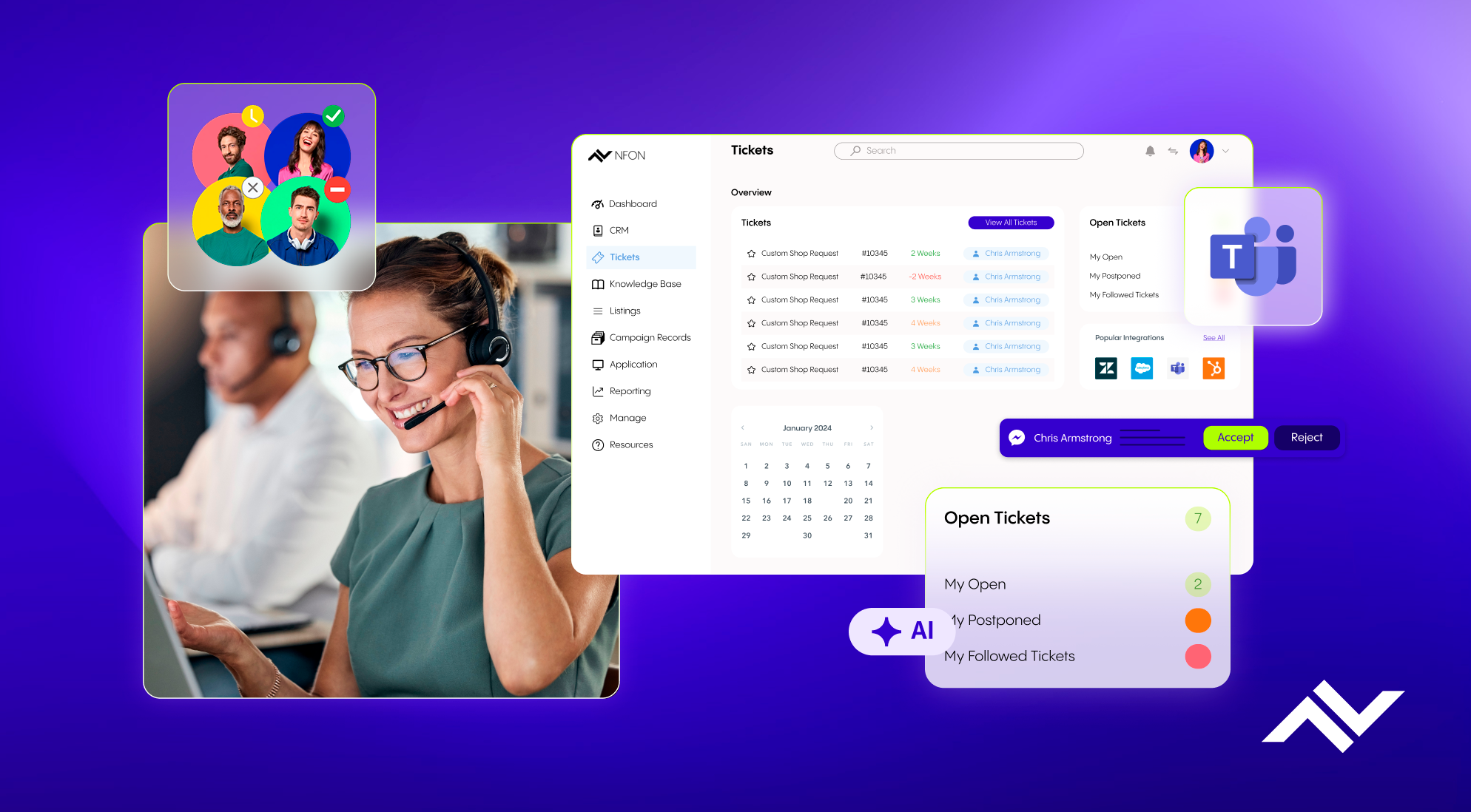

La sicurezza, quando si parla di dati, è essenziale. Per questo NFON lavora da anni per offrire ai suoi clienti soluzioni in cloud innovative, che mettano sempre la sicurezza al primo posto. Come Cloudya, il centralino in cloud di NFON, che dà la possibilità di avere sempre a portata di mano tutti i contatti, le chiamate e tutte le conversazioni (telefoniche, email, messaggi di segreteria e FAX) attraverso il servizio multitelefono, che consente di collegare fino a 9 dispositivi allo stesso numero di telefono ed email. Il tutto con un particolare focus sulla cyber security e in pieno rispetto delle normative vigenti. Oltre a utilizzare la crittografia a protezione dei dati, infatti, Cloudya permette l’accesso ai servizi attraverso l’uso di un PIN personale.

.jpeg)

.png)